计算机视觉是目前人工智能行业一个非常热门的领域。

前日我们对国外一家著名的成人视频网站进行了报道,该网站推出了一款成人视频识别引擎,由 AI 驱动,使用计算机视觉技术自主检测和识别成人视频中的内容以及表演者。

成人视频网站都这么努力地在使用人工智能技术来提升自身「技术含量」,世界最大的在线视频网站又怎么会无动于衷呢?

2006 年 11 月,Google 以 16.5 亿美元收购了著名在线视频网站 YouTube,在现在看来这是个聪明无比的决定,虽然 YouTube 一直难以盈利,但对全面转型「AI 优先」的 Google 来说,YouTube 上数不尽的视频资源毫无疑问是培养「优质 AI」的最佳数据土壤。

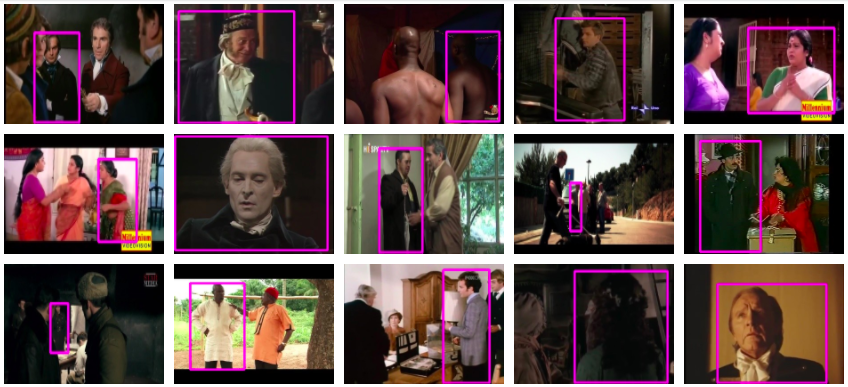

10 月 19 日,Google 发布了一个电影片段的数据集(dataset),旨在训练机器识别人类的动作,这个数据集被称为 AVA(原子视觉动作)。

在人类看来,这些视频片段并没有什么特别之处,大多是从 YouTube 上剪辑而来的 3 秒视频片段,人类在视频中喝水、做饭、拥抱、聊天。但每段视频都与一个文件绑定在一起,这个文件对人类的动作进行了描述,同时标注了视频中的人是否在于另一个人类或物体交互。

这就好像在教小孩说话的大人,指着一只柴犬说:「狗。」

当视频中出现不止一个人时,每个人都有自己的标注,这样算法就可以识别到人类相互握手的动作。

这项技术一方面可以帮助 Google 分析在 YouTube 上的视频内容,以便于更好地分发广告,或者判断视频内容是否含有暴力和情色等令人不适的内容。

但这样做的终极目标是训练计算机视觉的「智力」。

作者在附件里的研究论文中表示,这意味着机器正在「了解人类在做什么、接下来会做什么,以及他们的目的是什么」。

AVA 数据集拥有 57600 个标记的视频和 80 个人类行为。简单的动作如站、说、听、走等在数据集中被多次标记,每个均有 10000 个以上的对应视频。

然而,研究团队也表示使用电影片段会让机器产生一些「偏见」。因为电影表演与现实生活中人类的行为仍有一定的区别,很多动作在电影中都会被夸张和戏剧化。

「我们并不认为这些数据已经很完美了,」研究人员在论文中说道,「但如果使用用户上传的内容效果会更好,比如 DIY 教程和孩子的生日 party 等等。」

头图来源:视觉中国返回搜狐,查看更多

责任编辑: