10月19日,一篇题为《今日Nature: 人工智能从0到1, 无师自通完爆AlphaGo100-0 | 深度解析》的文章刷爆了朋友圈。

据文章介绍,去年打败围棋世界冠军的AlphaGo这次下棋输了,打败他的是从没学过人类棋谱,自己左右互搏无师自通的弟弟AlphaGo Zero。AlphaGo在48个TPU上花了几个月的时间,学习三千万棋局才打败人类,但AlphaGo Zero仅在4个TPU上花三天时间,自己左右互搏490万棋局就以100:0打败了它的哥哥。

杜克大学的AI专家陈怡然教授认为,这项新进展最有趣的是证明了人类经验由于样本空间大小的限制,往往都收敛于局部最优而不自知(或无法发现),而机器学习可以突破这个限制。人类的下棋数据或许会将算法导向了局部最优(local optima),但实际更优或者最优的下法与人类的下法存在一些本质的不同,学习人类棋谱的Alpha Go受到了误导。

什么是局部最优?

通常的优化算法,针对凸问题可以得到全局最优解;但对于非凸问题,梯度下降算法等常用优化算法时常陷入局部最优解。这是因为在局部最优点梯度变化非常小,算法会认为已经收敛,于是结束于这个局部最优点。

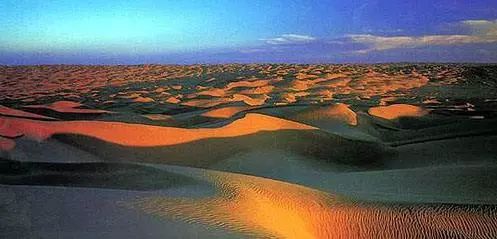

什么是局部最优?举一个通俗的例子。已知大海比珠峰低,假设你正站在珠峰上,老板告诉你目标是走到大海并且给你一个算法:只要你一直往下走就能走到大海。

于是你环顾四周,看见低处就往下走。如果你出发时往南走,就能走到印度洋;可如果你出发时往北走,当你走到塔里木盆地中心时,环顾四周就会发现没有身边不再有更低的地方,于是你会停下来,并且误以为自己已经到达大海。

于例子中的你而言,塔里木盆地就是局部最优解。

延伸来说,你的视野是一个固定参数,它决定你找到解的速度和陷入局部最优的概率。

如何避免陷入局部最优?

在视野固定的前提下,如果你需要提高走向大海,而非陷于塔里木盆地的概率,有一个简单有效的解决办法——老板在给你的算法中加入随机性,比如“你随机走动,尽可能探索更多的土地,直到你发现最低处”。

这就是AlphaGo Zero的逻辑,它没有利用任何人类的历史棋局,训练过程从完全随机开始,随机的训练使它有机会进行更多探索,提高了发现“更低处”的概率。所以,在经历了490万次随机的互搏后,AlphaGo Zero就幸运地找到了“更低处”,战胜了模仿人类3000多万次,被人类在“塔里木盆地”画地为牢的哥哥AlphaGo。

在放弃学习人类棋手的走法以及人工提取特征之后,算法能够取得更优秀的表现,这体现出深度神经网络强大的特征提取能力以及寻找更优解的能力。更重要的是,通过摆脱对人类经验和辅助的依赖,类似的深度强化学习算法或许能更容易地被广泛应用到其他人类缺乏了解或是缺乏大量标注数据的领域。

AlphaGo败北的启示

一位读者评论道,“AlphaGo Zero的逻辑基础其实和进化论很相似,都是先制定规则,然后根据规则演化,优秀的获得奖励,不好的遭受淘汰,不带任何过去经验的偏见。计算机拥有效率优势,可以在短时间内遍历几乎所有可能,摆脱局部最优;但人类的局限恰好在于向前迈进的成本太大,所以过分依赖过去的经验,曾经认为可能为错的,便不再去发展。”

鲜有人会不依赖经验地勇敢探索,我们通常百般权衡,或观望试探,或谋求捷径。当一张写着short cut或者better choice的路牌出现在眼前,我们情不自禁地按照它的指示前行。

但在人生的迷雾里插满了前人留下的路牌,如果我们不愿意自己去探索可能存在的曲折与崎岖,我们相信有一条更快捷和优美的小路,我们不断地去做出看似更便捷的选择,最终究竟会驶向何方,又还有谁能够定论?

生命的舵手在寻求的局部最优解里陷入了困境。

▼

本文为北大新媒体原创,转载请注明出处返回搜狐,查看更多

责任编辑: